技术SEO是指改进网站的技术方面,以提高网站页面在搜索引擎的排名。技术SEO的重要元素是从技术方面帮助搜索引擎更快更好地抓取、索引、呈现,以及从网站架构、加载速度、渲染、安全、移动端适应性等方面改善用户体验。

1. 架构

1.1 CMS

CMS 即内容管理系统(Content Management System)是一种用于创建和管理数字内容的系统,通俗地说,就是网站建站系统。使用CMS的好处是用户可以无代码控制网站的设计和内容,同时使用有限的资源大规模构建和管理复杂的功能。对于想要通过自建独立外贸网站SEO大展宏图的外贸企业来说,最好选择可自由定制、SEO友好的CMS来建立自己的网站,比如Wordpress。

优秀的CMS系统可以把搜索引擎优化集成到系统里,支持自响应设计,有丰富的视觉设计效果和交互式体验,可根据功能需要安装对应的插件实现功能的轻松升级,以及方便地集成功能强大的分析工具帮助进行业务数据的分析处理,实现以业务为中心,所想所见即所得。

1.2 网站结构

一个新站开始建设,网站的逻辑结构是所有技术SEO的地基,结构设计不当会产生搜索引擎抓取和索引的问题,强大的结构可以使技术SEO任务变得更加容易。而不良的结构使所有技术SEO工作大打折扣。

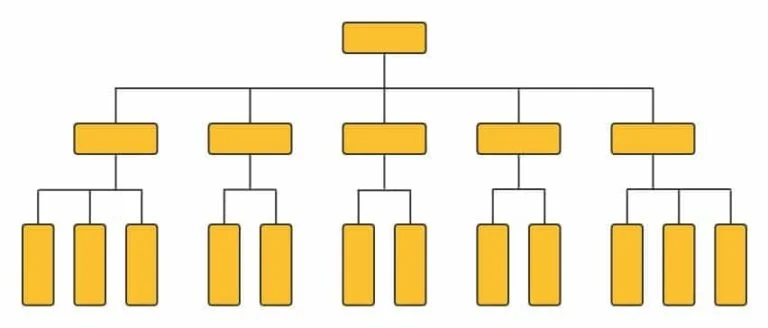

扁平结构

扁平的结构使蜘蛛程序,无论从哪个页面开始,只需爬很少几个链接,就可以到达网站的任何一个页面。扁平结构的网站可以使页面的搜索引擎抓取率轻松达到100%。

有组织的URL

有组织的URL结构可以帮助用户了解他们在网站上的位置。一般你可以把你的页面归类到不同的类别下面,像一个个文件档案一样。对搜索引擎来说,虽然URL对排名没有影响,但在富结果呈现方面有着积极作用。

站点链接

合理的网站结构有利于在谷歌搜索结果中生成站点链接(Sitelinks)。站点链接是谷歌自动分析逻辑结构,以帮助用户快速找到需要的信息。其重点便是要创建便于用户浏览的合理网站结构,确保重要网页与其他网页之间有丰富的内部链接。图中显示的是谷歌开发者博客的主搜索结果(1)和站点链接(2):

1.3 导航

面包屑导航可以自动将网页的内部链接添加到网站的类别上,对SEO非常友好,有助于改善网站结构。用户也可很方便地了解当前页面所处的位置和所属类别,点击一下即可到达页面所属的上一级类别。

2. 抓取和索引

robots.txt

robots.txt 是一种存放于网站根目录下的ASCII编码的文本文件,它告诉搜索引擎哪些位置可以访问,哪些位置不能访问。但需要注意的是,robots.txt 并不能百分之百保证你不想被抓取的网页不被索引。

访问限制

网站可以使用登录系统或IP白名单的方式限制搜索引擎访问,只允许你授权的用户登录访问特定页面。举个例子,比如某些只对会员开放的内容,只允许会员登录,而搜索引擎无法访问它们。

Googlebot抓取速度限制

如果谷歌每秒发出过多的抓取请求并影响到了网站服务器的速度,网站站长可以通过谷歌Search Console的抓取速度调整选项,来限制Googlebot抓取网站的速度。

重复页面

大多数网站都会存在一些重复的内容,这可能是在创建网页过程中的不同版本保存多次形成的。当这些相同的内容被索引时,就会成为一个问题。我们可以通过几种办法解决。

- noindex 标签:在不想被收录的网页中加入“noindex”标签,这个标签就会告诉搜索引擎不用索引页面;

- robots.txt 禁止收录:你可以直接在robots批量禁止搜索引擎抓取。

相似页面

除了重复内容之后,还有一种情况,是相似内容,而且这些相似内容是需要被谷歌收录的,这时候就可以用到第三种办法:规范化标签(Canonical tags)。使用这个标签就是告诉搜索引擎,加入了这个标签的网页就是众多相似页面中的主要页面。以购物网站为例,一个产品的每个尺寸、颜色、花式都可能导致不同的URL,这时可以用规范化标签让Google知道原始版本是主要页面,其他都是变体。

站点地图

站点地图是一个 XML 文件,列出了你的网站上的所有重要内容,包括Post文章、Page页面、图片。你把你的新网站的XML站点地图提交给搜索引擎站长工具(在这之前要先添加网站并完成验证),就像是在告诉搜索引擎:我的新站上线啦,快来收录我吧!这样搜索引擎就知道了,然后蜘蛛会来爬取你的网站,经过分析处理之后,搜索引擎会把你的网页编进它的索引里。不过是不是提交了就会百分百收录呢?并不会。只有不存在问题的规范化的网页才能被收录。你需要在搜索引擎收录去检查一下索引覆盖率,看看具体的收录数据。

覆盖率

谷歌Search Console有一个索引覆盖率统计,我们可以查看网站被收录的有效网页是多少,错误网页有多少,警告网页有多少,被排除的网页有多少。对比一下站点地图和有效网页,查看有没有网页是你想被收录而没有被收录的。检查发生错误、警告网页的具体问题类型,通过技术SEO方法修改调整之后,重新提交,经谷歌验证通过后转为有效网页。

网址检查

Search Console网址检查工具,可以提供特定网页被谷歌收录的状态。包括有无收录,覆盖率如何,移动设备易用性、路径和站点链接搜索框。当新的网页上传之时,可以通过网址检查工具提醒谷歌抓取并索引。

死链检查

死链是指,超链接在经过一段时间后,不能再连接至原本文件、网页、服务器的现象。其实只要设置了404页面,死链并不会成为排名问题。不过万一内部链接是死链呢,就是影响用户体验和蜘蛛爬取的大问题了。SEO可以使用死链分析工具来定期检查并修复死链问题,好用的工具如 SEMRush,Ahref 或 Screaming Frog 等。

重定向

301重定向指的是一个URL永久地定向到另一个URL。主要用于旧的URL(比如检查出来的死链)指向新的URL;网站域名变更时,旧的域指向新的域;带www指向不带www,相反亦如是;http指向https。

此外,如果是临时迁移,可使用302重定向。

3. 性能

3.1 核心网页指标

谷歌一直强调页面体验对于用户的价值,不断优化用户体验是网站取得长远成功的关键。2021年6月,谷歌发布了一个核心算法更新:页面体验。核心网页指标(CWV,Core Web Vitals)作为页面体验的一部分,成为今后SEO需要特别重视的排名因素。

多年来,谷歌为提升网站性能提供诸多的性能测量和报告工具,这些工具可能非常专业,只有小部分开发者比较精通。所以谷歌为了简化这些工作,提出了最重要的三个指标(加载性能、交互性、视觉稳定性)作为考察因素,即核心网页指标:LCP、FID、CLS。

- Largest Contentful Paint(LCP):最大内容绘制,测量页面加载时间,理想值应小于2.5秒。

- First Input Delay(FID):首次输入延迟,页面变为交互式所需的延迟时间,理想值应小于100毫秒。

- Cumulative Layout Shift(CLS):累计布局偏移,测量视觉内容的累积偏移量,理想值应小于0.1。

全面地测量CWV有两种途径:真实用户监控(RUM)和实验室数据测量。RUM需要真实用户数据的支持,适用于已经有一定历史数据的网站。从PageSpeed Insights 和 Search Console 可以得到相应的历史性能数据报告。此外还可以找专门的RUM第三方供应商提供分析报告和优化解决方案。实验室数据,是在预上线环境中模拟、合成出来的数据。可以使用的工具包括 PageSpeed Insights,Lighthouse 和 Webpage Test等。

实验室数据与RUM数据会存在一定的偏差:CLS因为模拟环境干扰少,其数据会低于实际用户数据;FID无法在实验室测得,所以一般情况下可以用 Total Blocking Time 代替 FID。

下图是使用 PageSpeed Insights 工具测量 打工人联盟 某一网页桌面端的实验室数据:

至于对CWV的优化,这是一项复杂的工程,这里就不做展开了,有时间另文再做阐述。

3.2 AMP vs RWD

AMP 即移动加速网页(Accelerated Mobile Pages),是谷歌在2015年专门为加速移动端用户体验推出的开源HTML架构。RWD即响应式网页设计(Responsive Web Design),2010年推出,使用响应式网页设计,网站可以灵活地适应不同设备的屏幕,不用再为不同设备创建不同版本的网站。简而言之,AMP侧重于速度,而RWD侧重于灵活性。

AMP作为一种专门为制作超快速移动网页的架构,它采用专门的AMP JS,AMP HTML标签和专门的CSS样式表,并且把页面存储在谷歌服务器缓存中。一切都是为了快速,带来的缺点就是AMP仅适用于静态内容,无法添加第三方Javascript代码,以及只能使用非常有限的CSS。

RWD专注于网页适应不同设备的灵活性,对JS和CSS没有限制。缺点是加载偏慢,需要优化代码、压缩JS和CSS来加速。

AMP和RWD各有千秋,可以根据需求在两者之间做一个选择;也可以依靠专业的合作伙伴,使用结合AMP和RWD两种方式、既是响应式又有极致速度的解决方案,以达到最优的移动页面体验。

4. 安全

4.1 HTTP 还是 HTTPS

HTTP 全称是 HyperText Transfer Protocol(超文本传输协议),而 HTTPS 是 HyperText Transfer Protocol Secure(超文本传输安全协议)。HTTPS 还是经由 HTTP 进行网络通信,但是利用 SSL/TLS 来加密数据包。毫无疑问,安全的网络传输协议肯定是好处多多。谷歌早在2010年就开始鼓励网站使用 HTTPS,到了2018年谷歌 Chrome 开始向点击非 HTTPS 网站的用户发出警告,由用户确认之后才能登录目标网站。其他浏览器也迅速跟进。

下图是一个SSL证书刚刚过期的网站,经由 Safari浏览器登录时,所展现的警告。每个新访问者都会经历一次这样的警告,这是非常影响用户体验的不愉快事件,以及降低SEO成效的败笔。

目前Google没有确认HTTPS是排名因素,但是研究发现,HTTPS对搜索结果确实有积极影响。HTTPS的最大优势还是提供安全可靠的浏览体验,避免客户因为不安全警告而远离你的网站。此外,要使用AMP必须是HTTPS的站点,谷歌广告的投放时也会对非HTTPS的网站打上警告标记。虽然HTTP的网站对投放本身不影响,但是当用户点击你的广告时,却得到了不安全警告,这非常不利于用户体验以及转化率。

其实要升级HTTPS不麻烦,只需找到合适的SSL证书,进行安装,然后对站点页面重定向,并更新相应的设置即可。SSL证书可以根据你的网站所需的安全等级来进行选择,一般不进行在线交易的网站,只需选用免费的证书就可以了。Let’s Encrypt提供免费的基础等级SSL证书。现在比较专业的服务器空间提供商会集成安装免费SSL证书的选项。当然自己从证书提供商那里下载过来安装也可以。但是市面上有些第三方建站商会忽悠你,明明是免费拿来的SSL证书,会以不菲的价格卖给你。小心不要踩坑。

4.2 站点垃圾

上文讲到过垃圾信息是违反谷歌的质量指南的,其实网站上的垃圾不一定是我们自己产生的,也有可能是用户生成的一些垃圾内容,比如一些垃圾账号、论坛的垃圾帖子、博客的垃圾评论等。这些恶意网络垃圾会干扰用户的正常体验,拖慢网站的速度,影响网页的排名,情节严重的会受到谷歌的惩罚。

因此,要仔细考虑之后再决定是不是需要评论功能,有评论功能的要主动监控并及时清理恶意的垃圾评论。增加用户注册真人验证程序,防止网络垃圾机器人自动创建账号并发布垃圾信息,这个程序可以用谷歌的Google reCAPTCHA服务。对所有的评论自动添加nofollow属性,防止把用户评论里的链接纳入 PageRank 算法,进而影响SEO成效。另外,还可以使用 noindex 标签或者 robots.txt 主动屏蔽用户创建的不受信任的页面。

4.3 恶意入侵

网站如果存在安全漏洞会面临遭到黑客恶意入侵的风险。网站被黑后,可能会被注入恶意的内容、安装恶意软件、在正常内容背后加入隐藏的文字或链接、或者被重定向到有害、垃圾网页。网站被黑后,谷歌会直接从搜索结果中滤除被黑内容,并在危险网站或危险的下载文件上显示警告。遭到恶意入侵是一个网站最大的风险,偶然发生这一危机时,谷歌会给予机会进行修复,但是对屡次发生这种违规的网站,谷歌会冻结提交审核的权限一定期限。

虽然被黑后,还是有机会把挽救回来,但是对网站的排名和用户体验将会带来长期的负面影响。所以在平时一定要做好安全防范工作。

- 使用自定义的登录链接、登录名和安全的密码;

- 谨慎选择第三方的软件或服务;

- 安装网络防火墙,并定期查看监控日志;

- 关注Google Search Console的安全问题报告;

- 及时更新系统以及插件,防止落后版本中的漏洞被恶意利用;

- 做好网站备份,包括定期备份,以及重大更新时的备份;

- 使用HTTPS安全协议。

没有回复内容